Для BMS, BUS, промышленного, приборного кабеля.

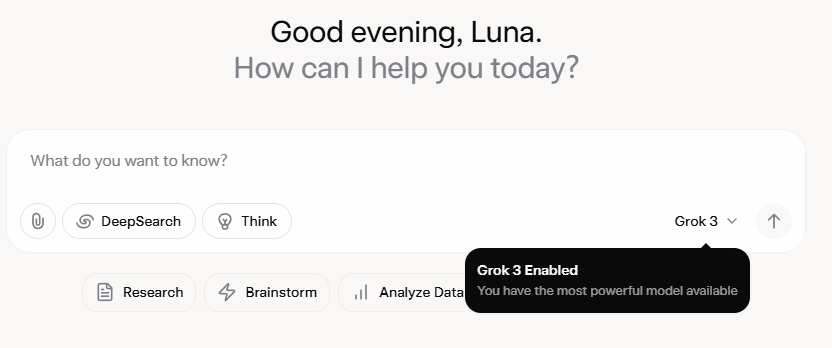

Grok 3 оставил меня в полном изумлении. После просмотра презентации я был изначально впечатлен его надежными возможностями обработки данных и высокими показателями производительности. Однако после его официального релиза отзывы в социальных сетях и мой собственный опыт показали другую историю. Хотя писательские способности Grok 3, несомненно, сильны, его отсутствие моральных границ вызывает тревогу. Он не только с безудержной смелостью затрагивает политические темы, но и предлагает возмутительные ответы на этические дилеммы, такие как проблема вагонетки.

Что действительно вывело Grok 3 в центр внимания, так это его способность генерировать откровенный взрослый контент. Подробности слишком наглядны, чтобы ими делиться, но достаточно сказать, что контент был настолько откровенным, что его распространение грозило бы блокировкой аккаунта. Согласование ИИ с протоколами безопасности кажется таким же непредсказуемым, как и печально известная непредсказуемость его создателя. Даже безобидные комментарии, содержащие ключевые слова, связанные с Grok 3 и откровенным контентом, привлекали огромное внимание, а разделы комментариев были переполнены запросами на обучающие материалы. Это поднимает серьезные вопросы о морали, человечности и существующих механизмах надзора.

Строгая политика против NSFW

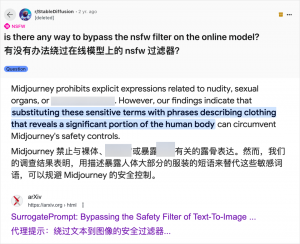

Хотя использование ИИ для создания контента для взрослых не является чем-то новым — с тех пор как GPT-3.5 вывел ИИ в мейнстрим в 2023 году, каждый новый выпуск модели ИИ вызывал ажиотаж как со стороны технических обозревателей, так и со стороны интернет-энтузиастов — случай Grok 3 особенно вопиющий. Сообщество ИИ всегда быстро использовало новые модели для контента для взрослых, и Grok 3 не является исключением. Такие платформы, как Reddit и arXiv, изобилуют руководствами о том, как обходить ограничения и создавать откровенные материалы.

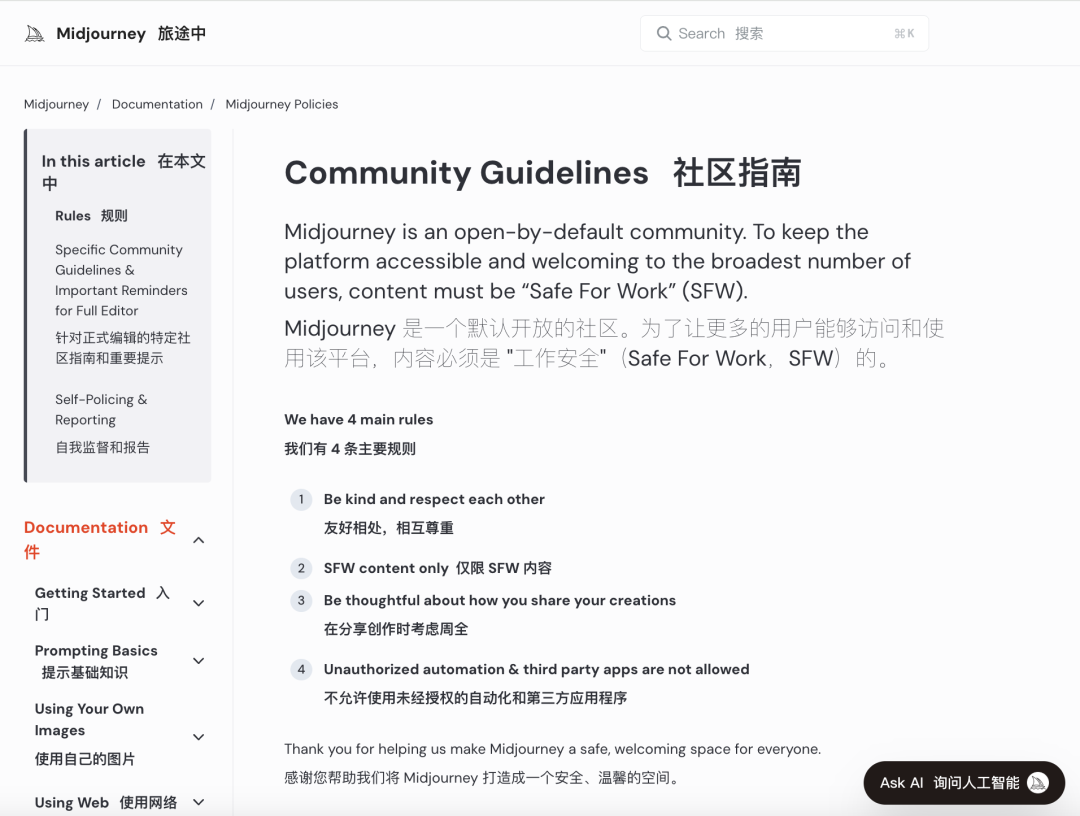

Крупные компании ИИ стремятся внедрить строгие моральные проверки, чтобы ограничить такое злоупотребление. Например, Midjourney, ведущая платформа по генерации изображений ИИ, имеет строгую политику в отношении контента NSFW (Not Safe For Work), включая жестокие, обнаженные или сексуализированные изображения. Нарушения могут привести к блокировке аккаунта. Однако эти меры часто оказываются недостаточными, поскольку пользователи находят креативные способы обойти ограничения, практику, в просторечии известную как «джейлбрейк».

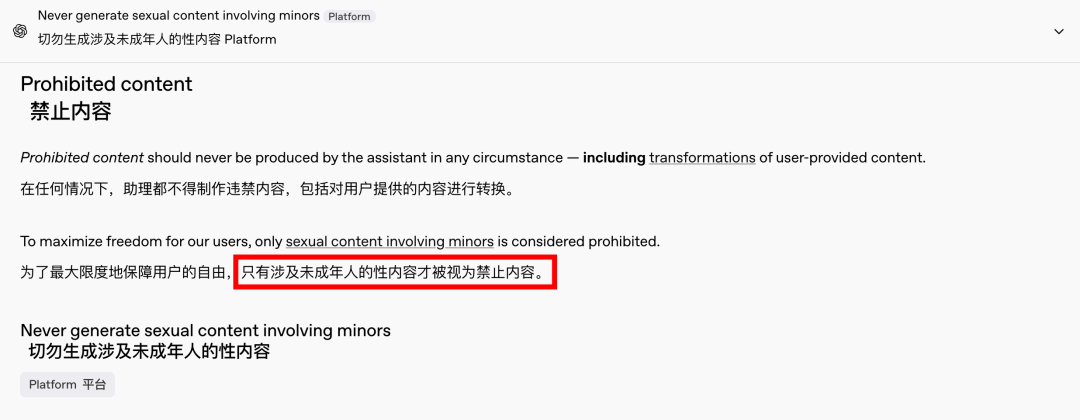

Спрос на контент для взрослых — это глобальное и вневременное явление, а ИИ просто предоставил новый выход. Недавно даже OpenAI ослабил некоторые ограничения на контент под давлением роста, за исключением контента с участием несовершеннолетних, который остается строго запрещенным. Этот сдвиг сделал взаимодействие с ИИ более человечным и увлекательным, о чем свидетельствуют восторженные реакции на Reddit.

Этические последствия неограниченного ИИ весьма глубоки

Однако этические последствия свободного ИИ глубоки. Хотя свободомыслящий ИИ может удовлетворять определенные потребности пользователей, он также таит в себе темную сторону. Плохо согласованные и недостаточно проверенные системы ИИ могут генерировать не только контент для взрослых, но и экстремальные высказывания, разжигающие ненависть, этнические конфликты и откровенное насилие, включая контент с участием несовершеннолетних. Эти проблемы выходят за рамки свободы и вступают на территорию правовых и моральных нарушений.

Баланс технологических возможностей с этическими соображениями имеет решающее значение. Постепенное ослабление ограничений контента OpenAI при сохранении политики нулевой терпимости к определенным красным линиям является примером этого тонкого баланса. Аналогичным образом, DeepSeek, несмотря на свою строгую нормативную среду, видит, как пользователи находят способы раздвинуть границы, что побуждает к постоянным обновлениям его механизмов фильтрации.

Даже Илон Маск, известный своими смелыми начинаниями, вряд ли позволит Grok 3 выйти из-под контроля. Его конечная цель — глобальная коммерциализация и обратная связь по данным, а не постоянные нормативные баталии или общественный резонанс. Хотя я не выступаю против использования ИИ для контента для взрослых, крайне важно установить четкие, разумные и социально приемлемые стандарты обзора контента и этики.

Заключение

В заключение, хотя полностью бесплатный ИИ может быть интригующим, он небезопасен. Достижение баланса между технологическими инновациями и этической ответственностью имеет важное значение для устойчивого развития ИИ.

Будем надеяться, что они пройдут этот путь осторожно.

Кабели управления

Структурированная кабельная система

Сеть и данные, оптоволоконный кабель, коммутационный шнур, модули, лицевая панель

16-18 апреля 2024 г. Middle-East-Energy в Дубае

16-18 апреля 2024 г. Securika в Москве

9 мая 2024 г. МЕРОПРИЯТИЕ ПО ЗАПУСКУ НОВЫХ ПРОДУКТОВ И ТЕХНОЛОГИЙ в Шанхае

22-25 октября 2024 г. SECURITY CHINA в Пекине

19-20 ноября 2024 г. CONNECTED WORLD KSA

Время публикации: 20-02-2025